被ChatGPT带飞的AIGC技术,国内外投资趋势

现在如果你还没有被 ChatGPT 刷屏,那你可能要反思一下自己是不是与世隔绝太久了。这一款基于深度学习的人工智能聊天 AI 应用简直是——

横空出世 上线仅2个月用户数突破一亿,新注册量还在飞速增加!

为所欲为 它快速的反应力和创造力让人惊呼:AI 留给人类的时间不多了!

红到发紫 它还在疯狂学习和进化,它还想做更多事!

但很多人还不知道,ChatGPT 其实属于一个大家庭—— AIGC 应用。

What is AIGC

AI-Generated Content ,通过人工智能技术自动生成内容的生产方式,生产的内容可以包括绘画、文字、音频、视频等等。最近爆火的 AI 绘画和 ChatGPT 就是 AIGC 的产物。

AIGC 这个词汇已经突破了最早的定义,成为一个充满想象力的行业名词,它有望成为数字内容创新发展的新引擎,为数字经济发展注入全新动能。在 AIGC 的世界里,你的一切想象都能通过 AI 帮你实现。

你能做些什么

你能想到的一切

这个行业里,长了翅膀的独角兽已在满天乱飞,AIGC会是下一个万亿市场吗?

为了回答你,万氪高科技行业研究小组联合外部智囊团,发布重磅干货——AIGC 行业报告。

看完这篇行业报告,能让你从0开始读懂这个突破人类与人工智能屏障的技术领域,快速了解现在市场上最新最牛的 AIGC应用(绝不仅仅只有 ChatGPT),找到支点进入这一风云最猛烈的未来行业。

科技下场,资本下场AI,企业下场AI

只要你准备好,人才就可以下场。

看点.

1

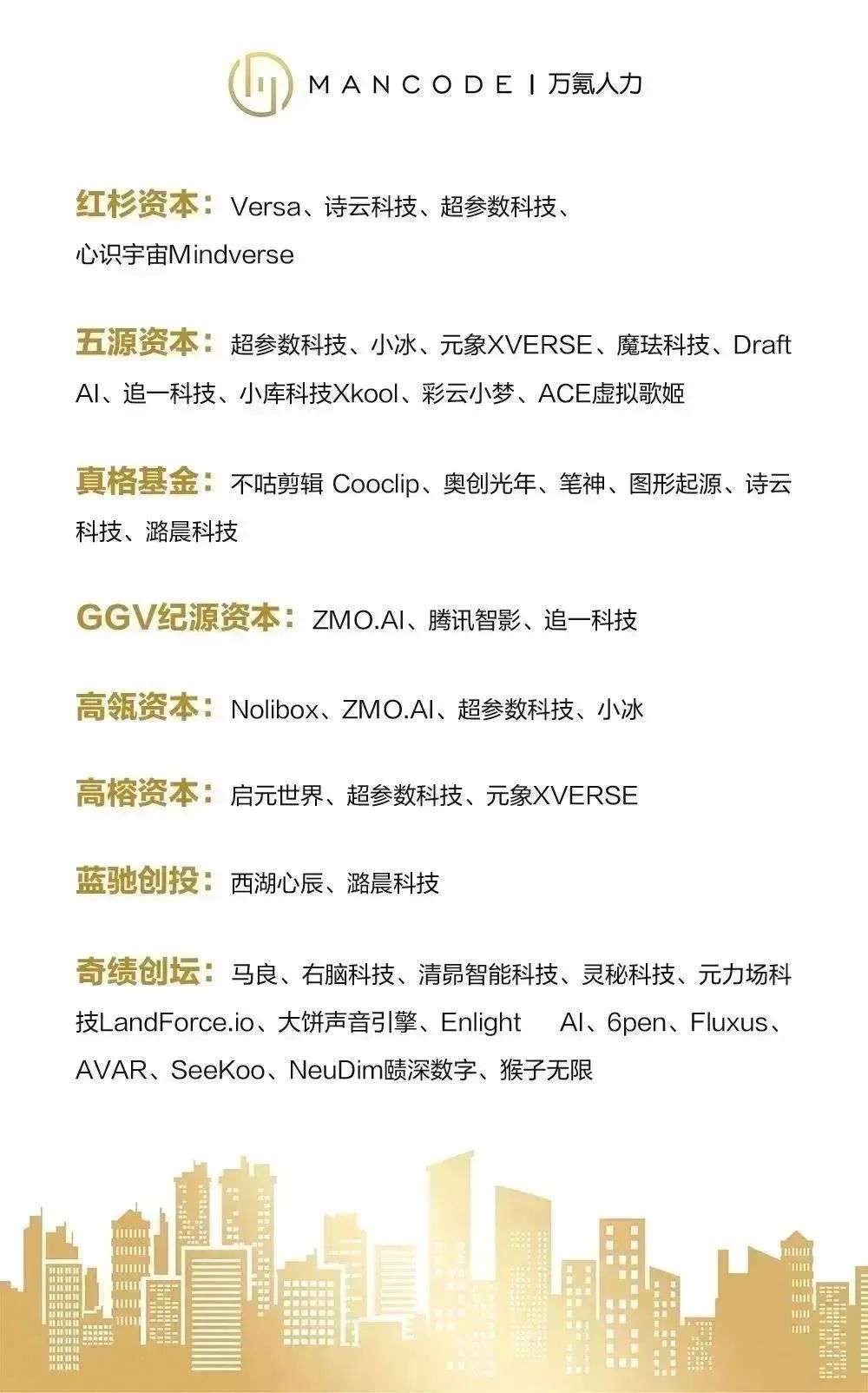

主要投资方

海外:

国内:

看点.

2

AIGC领域受到C端、B端用户及投资界的高度关注,在2022年实现了爆发式增长

2021年之前,AIGC生成内容仍局限在文字。2022年8月,在美国科罗拉多州举办的新兴数字艺术家竞赛中,参赛者提交AIGC绘画作品《太空歌剧院》,参赛者没有绘画基础但是却获得了此次比赛“数字艺术/数字修饰照片”类别一等奖,引发多方争议。2022年10月,Stability AI获1亿美元融资,估值近10亿美元;发布开源模型Stable Diffusion。

看点.

3

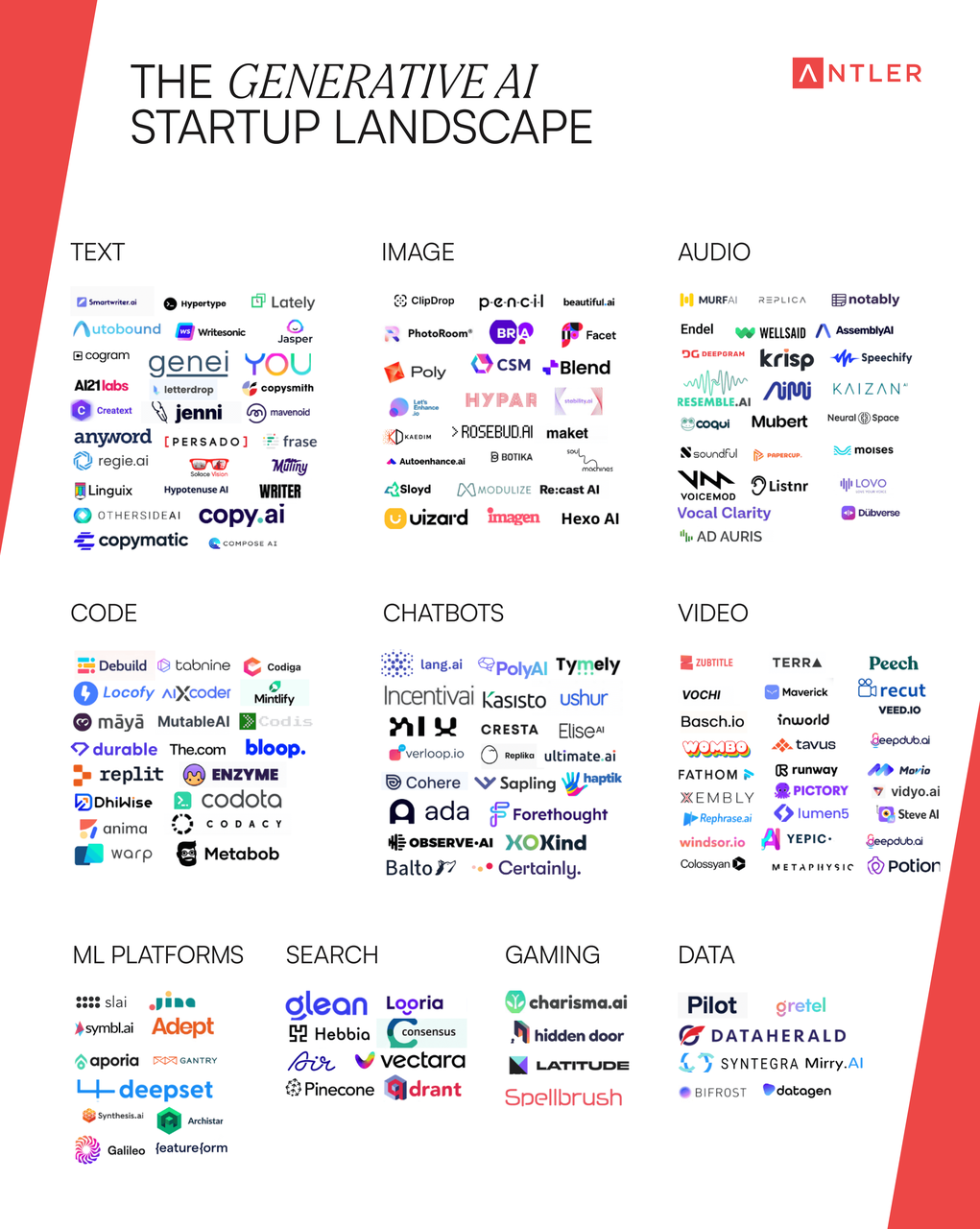

国内外项目全景扫描

国内:项目多处于起步阶段,头部产品尚未出现

海外:项目发展时间长,竞争格局较为清晰

看点.

4

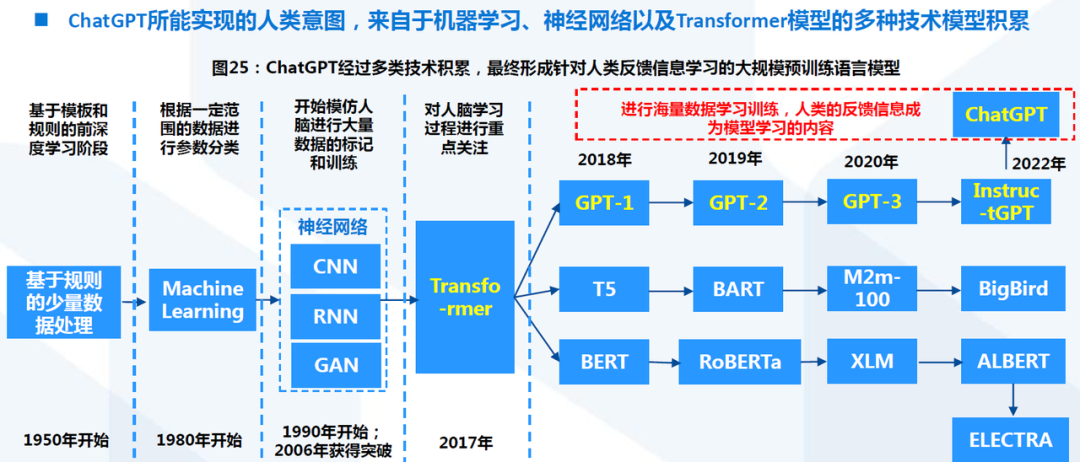

技术迭代过程

文本生成:Transformer模型早已出现,硬件改进、资本注入推动了文本生成领域的突破

机器学习、神经网络技术早在几十年前便已经得到了充分发展和应用。根据参数的数量进行分类,可将机器学习模型分为统计学习模型和深度学习模型,前者利用数学理论寻找较为优雅且简洁的求解方式,因此对于算力的要求不高;后者则更偏向于通过多层神经网络的堆叠,从而暴力逼近似然解,因此需要很强的算力进行并行计算。

此后基于深度学习模型,出现了Transformer模型模仿人脑的学习过程。Transformer模型的基本原理是根据每两个单词间的关系进行分析,从而理解单词在上下文中的含义。

简单来说,Transformer模型有三个主要特征:attention机制、迁移学习(Transfer Learning)和自监督学习(Self-Supervised Learning)。Attention机制是通过充分利用硬件并行结构充分利用算力;迁移学习,是指首先对泛化的各类文本进行训练,生成预训练模型,而后如果需要针对特定场景,仅需基于预训练模型进行定制化微调,展示少许该领域范例即可完成训练,无需重复训练;自监督学习,则是无需对训练数据进行标注,当 AI 拿到一个语料库,可以通过遮住一句话中的某个单词、遮住某句话的下一句话的方式,来模拟一个标注数据集,帮模型理解每个词的上下文语境,找到长文本之间的关联,从而大幅提高了对数据集的使用效率。

在2010年之前,统计学习模型仍是主流。Transformer等深度学习模型得以实现重大突破,则是建立在近几年两个层面上的支持。首先是计算机硬件的改进,GPU吞吐量和内存在过去四年中增加了10倍,而且可以通过硬件并行训练更多参数的模型架构、更加巨量的训练数据、更加多元的数据类型及采集渠道。

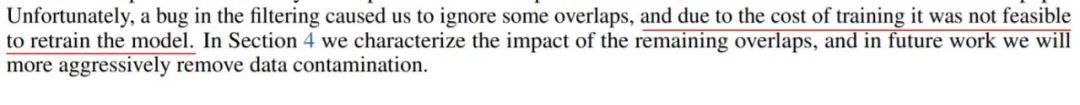

其次是众多科技公司及投资方对于文本生成AIGC的资金支持。在实际情况下要达到上述效果,成本不容小觑:从公开数据看,训练一个 BERT 模型租用云算力要花约 1.2 万美元,训练 GPT-2 每小时要花费 256 美元,但 OpenAI 并未公布总计时间成本。考虑到 GPT-3 需要的算力是 BERT 的 2000 多倍,预估发布当时的训练成本肯定是千万美元级别,以至于研究者在论文第九页说:我们发现了一个 Bug,但没钱再去重新训练模型,就先这么算了吧。

OpenAI由埃隆·马斯克、美国创业孵化器Y Combinator总裁阿尔特曼、PayPal联合创始人彼得·蒂尔等人于2015年创立,启动资金高达10亿美元。而后,2019年7月,微软向OpenAI投资了10亿美元,加速了OpenAI的模型迭代速度和商业化进程,随后在2020年6月,OpenAI便发布了第一款商业化产品OpenAI API。这一系列资金支持下,OpenAI得以在底层算法架构、硬件能力等方面实现快速发展。

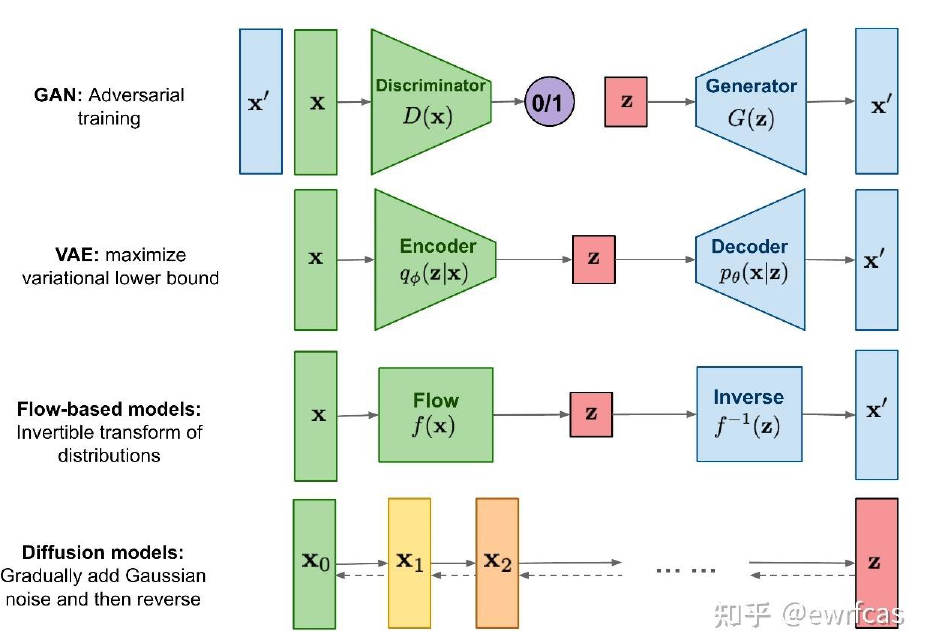

图像生成:最新出现的Diffusion扩散模型为主要推手,使得图像生成在算法层面实现重大跃迁

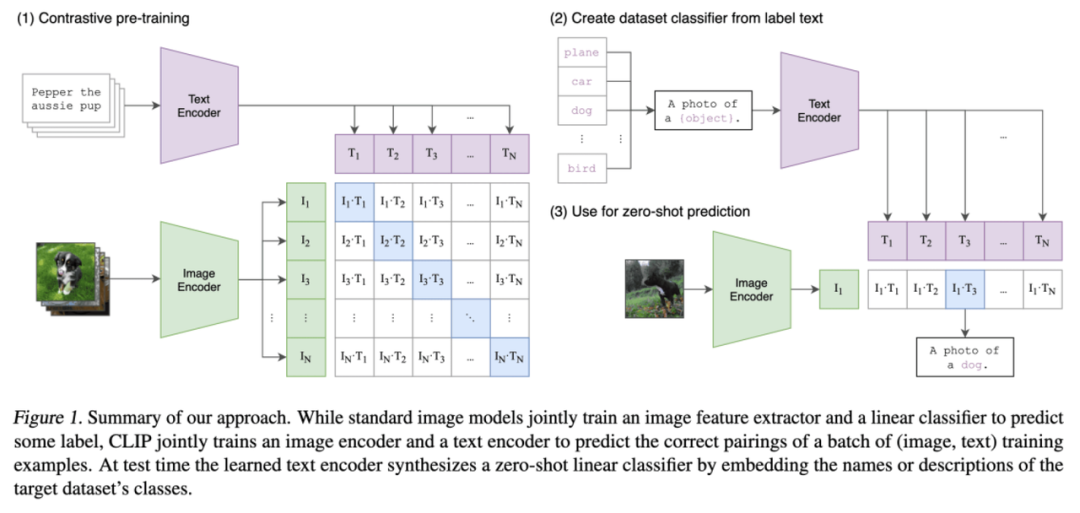

GPT-3完成后,OpenAI 把大模型的思路迁移到了图片多模态(Multimodal)生成领域,图片生成AIGC主要分为三个技术方向,即GAN/CLIP/Diffusion。

模型 | 出现时间 | 主要特点 |

GAN | 2014 | 1、生成器用来生成图片,判别器用来判断图片质量,两者互相平衡之后得到结果。 2、对输出结果的控制力较弱,容易产生随机图像、分辨率比较低。 |

CLIP | 2021 | 1、进行自然语言理解和计算机视觉分析。 2、使用已经标注好的“文字-图像”训练数据。一方面对文字进行模型训练。另一方面对图像进行另一个模型的训练,不断调整两个模型内部参数,使得模型分别输出的文字特征值和图像特征值并确认匹配。 |

Diffusion | 2022 | 1、通过增加噪声破坏训练数据来学习,然后找出如何逆转这种噪声过程以恢复原始图像。 2、经过训练,该模型可以应用这些去噪方法,从随机输入中合成新的“干净”数据。 |

早在2019年3月强化学习之父Richard Sutton发布了名为The Bitter Lesson的博客,其中提到:“短期内要使AI能力有所进步,研究者应寻求在模型中利用人类先验知识;但之于AI的发展,唯一的关键点是对算力资源的充分利用。”

“对抗生成网络”GAN(Generative Adverserial Network)包含两个模型,一个是生成模型(Generative Model),一个是判别模型(Discriminative Model)。生成模型的任务是生成看起来自然真实的、和原始数据相似的实例。判别模型的任务是判断给定的实例看起来是自然真实的还是人为伪造的(真实实例来源于数据集,伪造实例来源于生成模型)。

受博弈论启发,GAN 在训练一个子模型A的同时,训练另一个子模型B来判断A生成的是真实图像还是伪造图像,两者在一个极小极大的博弈中不断变强。当A生成足以“骗”过B的图像时,模型认为它比较好地拟合出了真实图像的数据分布,进而用于生成逼真的图像。因此,GAN模型生成的作品是对源数据的模仿而非创新,也无法自由控制输出结果。

前期的AIGC项目大多使用GAN模型,但是GAN模型天生具有不足性,这也导致前期的AIGC生成结果不甚理想,仅能处理较为简单的任务。

CLIP (Contrastive Language-Image Pre-Training)模型的原理是将文字与图像的多重特征进行关联,因此需要用足够多已经进行标记的“文本-图像”进行训练,目前的CLIP模型已经利用互联网上超过40亿个数据进行训练。简单来说,人类浏览图像之后会对图像进行文字总结,因此模型根据文字和图像间的历史训练数据对需要识别的文字-图像进行匹配度打分。

AIGC行业实现大规模爆发的最终推手,则是最新出现的Diffusion扩散化模型。简单来说,Diffusion扩散化模型中存在一系列高斯噪声(T 轮),将输入图片X0变为纯高斯噪声Xt,模型的训练过程则是负责将Xt复原回图片X0。它在发表之初其实并没有收到太多的关注,主要有两点原因,其一灵感来自于热力学领域,理解成本稍高,其二计算成本更高,对于大多高校学术实验室的显卡配置而言,训练时间比 GAN 更长更难接受。

该模型通过主动增加图片中的噪音破坏训练数据,然后模型反复训练找出如何逆转这种噪音过程恢复原始图像,训练完成后扩散模型就可以应用去噪方法从随机输入中合成新颖的“干净”数据。

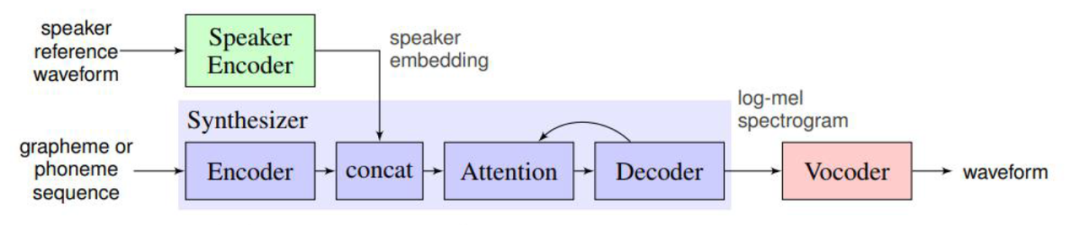

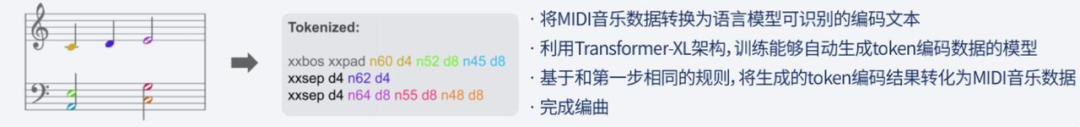

音频生成:TTS场景较为成熟,技术暂未出现更大突破;AI作曲为Transformer模型+MIDI转化

TTS(Text-to-speech)场景主要包括客服及硬件机器人、有声读物制作、语音播报等,其中具有代表性的模型有WaveNet、Deep Voice及Tacotron,技术在前几年已经较为成熟。

目前新兴领域为语音克隆,即对特定的目标语音进行模仿,对于未来虚拟人、电影、动画及游戏AI NPC具有重要意义,但技术仍不成熟。

AI作曲领域主要是“以语言模型(目前以Transformer为代表,如谷歌Megenta、OpenAI Jukebox、AIVA等)为中介,对音乐数据进行双向转化(通过MIDI等转化路径)”

视频生成:视频AI自动剪辑技术仍处于尝试阶段,视频片段生成与图像生成技术路线类似

基于视频中的画面、声音等多模态信息的特征融合进行学习,按照氛围、情绪等高级语义限定,对满足条件片段进行检测并合成。目前还主要在技术尝试阶段。典型案例包括Adobe与斯坦福共同研发的AI视频剪辑系统、IBM Watson自动剪辑电影预告片、以及Flow Machine。

视频片段生成技术原理与图像生成类似,本质上是生成每一帧图像,而后进行合成。过程中需要对保证合成图像间的流畅度和真实度,因此目前技术的主要方向是提升修改精准度与修改实时性两方面。

看点.

5

业内评价

早在2019年3月强化学习之父Richard Sutton发布了名为The Bitter Lesson的博客,其中提到:“短期内要使AI能力有所进步,研究者应寻求在模型中利用人类先验知识;但之于AI的发展,唯一的关键点是对算力资源的充分利用。”

Midjourney创始人David Holz评价AI:

Stable Diffusion的开源直接引发2022年下半年AIGC引发广泛关注,短短几个月时间内出现大量二次开发。针对为何各家公司选择开源,著名的科技战略书籍,乔尔·斯波尔斯基的《战略信条》解释为什么大公司会投资开源软件时写下这句话:

看点.

6

技术迭代的未来发展方向

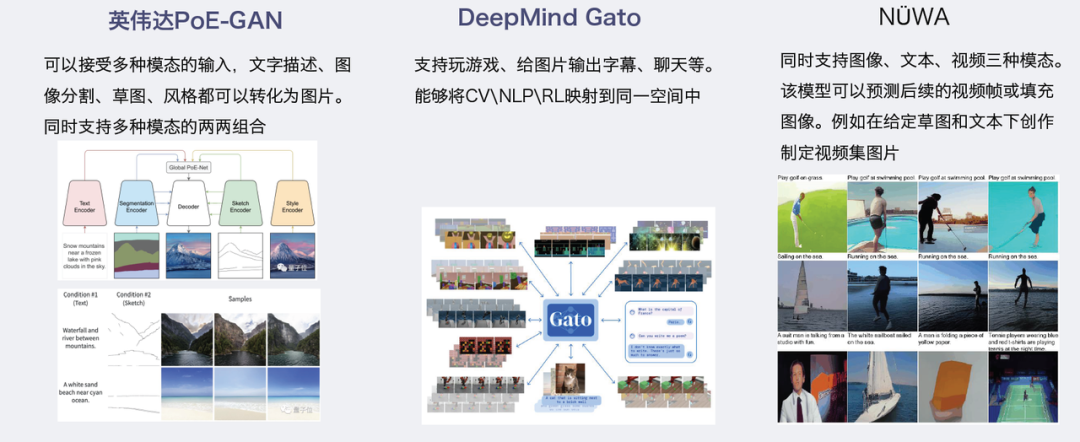

目前AIGC生成正在完成从简单的降本增效(以生成金融/体育新闻为代表)向创造额外价值(以提供绘画创作素材为代表)转移,跨模态/多模态MML(Multi-modal Learning)内容成为关键的发展节点。例如,根据文字生成图像、视频,基于视频进行视觉问答等。

Transformer架构的跨界应用成为跨模态学习的重要开端之一。在未来1-2年,“文字—图像”的生成将快速落地。目前,“文字-视频”的生成也已有相对理想的实验效果,三个模态的跨模态生成也已经开始尝试。

另一方面,目前模仿人脑神经网络的模型,参数总量约在千亿量级;与之对应的人类大脑有近100万亿神经元,其中每100个神经元组成一个皮质柱,可以理解为模型中一个小的神经网络模块。因此,通过堆叠算力从而优化模型的可提升空间仍较大。加之数据统计显示,训练成本每年约降低60%,目前训练1750亿参数的GPT-3的成本大概在450万美元左右,则未来不断衍生出的一系列AIGC产品,则会具有较高的业务想象空间。

后记

特别感谢跨界智囊团:来自互联网大厂的产品、战投、市场,Top3大学的战略研究员。

此报告打破传统线下团队模式以巴克球协作形式共创完成。